7000字深度长文丨AI深处令人恐惧的阴暗秘密

- 科技

- 1周前

- 52

机器学习科技在其本质上就比手工编码系统更晦涩难懂,就算对于计算机科学家亦是如此。当然,这并不是说将来所有的AI技术都将变得难以理解,我们只是提出在本质上,深度学习本身就是一个神秘的黑匣子。

仅仅深入看看深度神经系统里到底是什么是不足以弄清它的工作原理的。一个网络的推理运算包含于成千上万个模拟神经元的行为之中,再被分配至几十个,甚至是几百个错综复杂的内部联结层级之中。神经元是接收输入信息的第一层。比如一张图片的像素亮度首先发送至神经元,接着才会执行运算,输出新信号。输出信号将流入复杂的网络,传送至下一层级的神经元。如此周而复始,直到机器完成输出。在此期间,单独的神经元会纠正其运算以求最好的输出结果,因此这一过程也被称为“反向传播”。

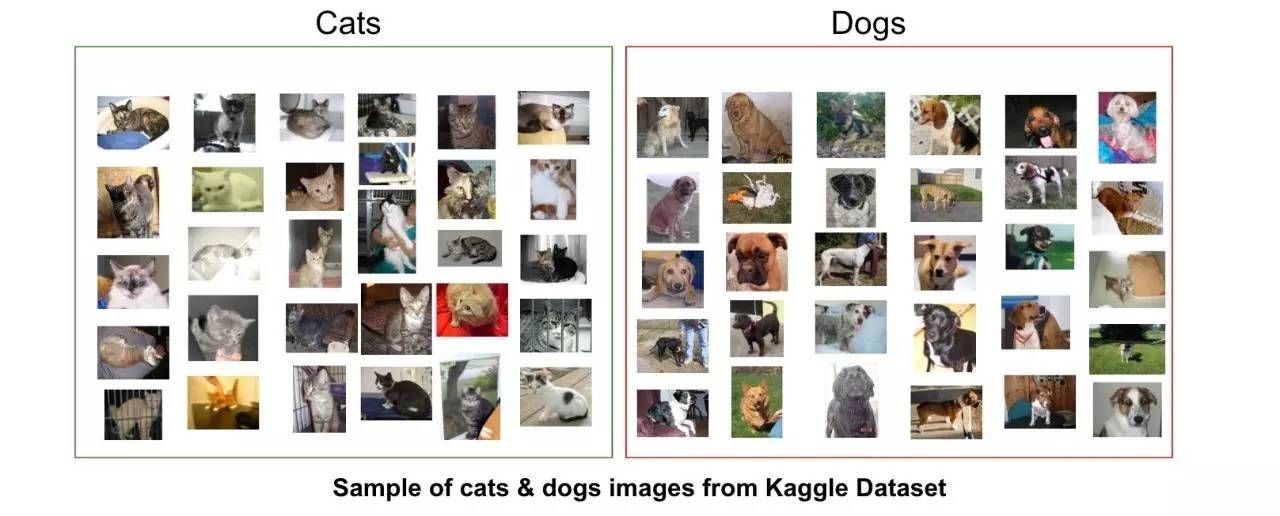

一个深度网络中的不同层级可以在不同的抽象级别上识别事物。如果是一个专为识别狗的系统,那么最低层次就负责识别最简单的特征,例如狗的轮廓或是颜色;高级一些的层次就负责识别略为复杂的特征,比如毛发和眼睛等;最后,最高层次就负责鉴定狗的品种。简单来说,这种做法就可以应用于别的机器输入,自学人类经验,例如演讲的声音、书信中的语言文字或者汽车行驶时该如何操作方向盘。

当然,已经有人用独创的战略设备试图捕获机器运行的步骤,以更详细地解释系统运行时到底发生了什么。2015年是,的研究员修缮了某个建立于深度学习的图像识别算法,之后,这一算法不仅能简单地在照片中定位物品,更能直接生产物品或者改变物品。通过反向运行算法,研究员们得以理解这一程序如何识别照片上的物体。以照片上的小鸟和建筑举例,在这个名为“深度梦境”(Deep Dream)的工程最终显示的图像上,形似外星人的动物逐渐从云端与植被中显现,梦幻模糊的佛塔渐渐透过森林和山脉跃然纸上。这些图像证明了,深度学习也并不一定全是高深莫测的,的研究员就成功地解密了这些熟悉的图像是如何被识别的。不过这些图像也同样在预告我们深度学习与人类认知的巨大差距,这样一来,人们甚至可能忽略人工智能产生的一些结果。的研究员注意到,当算法绘制出一幅哑铃的图像,它也同时绘制出了举起哑铃的手臂。因为在机器看来,手臂已经是哑铃的一部分了。

借着神经科学和认知科学的助力,人工智能再进一步。美国怀俄明州立大学的助理教授Jeff Clune带领了一个小队,用光学错觉等效人工智能来测试深度神经网络。2015年,Clune的团队发现一旦图像采用了机器系统正在搜寻的低级的模式,神经网络就会被这些图像欺骗,接收到根本不存在的信息。Clune的合作人Jason 同样建立了用以探测大脑的工具。这一探测工具旨在监测神经网络中央的一些神经元,从中找出到底是哪些图像最能刺激神经。研究发现,图像大多是抽象的(比如印象派画风的火烈鸟,或者校车之类的),这也进一步证明了机器感知能力的神秘性。

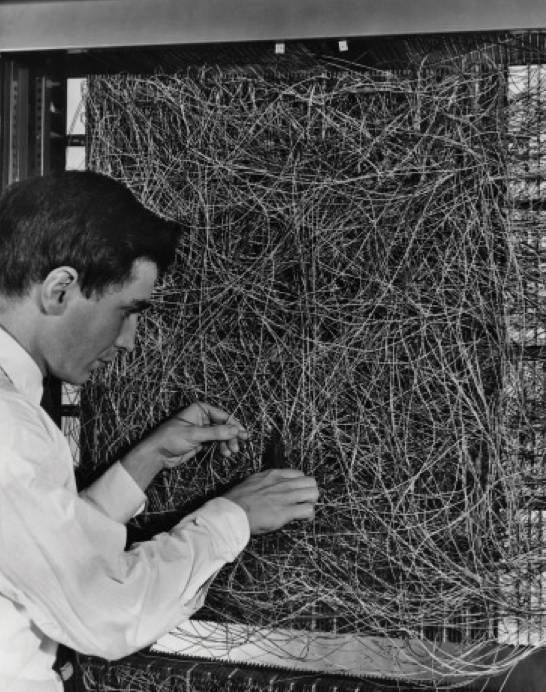

(图为1960年,早期的人工神经网络处理灯光传感器的输出流程,位于纽约水牛城康奈尔航空实验室)

然而,对于人工智能的“思考方式”,仅仅管中窥豹远远不够。深度神经网络中运算程序的交互作用才是高级认知和复杂决策的关键因素,然而这些运算对于数学方程和变量却宛如泥沼。“假如只是一个很小的神经网络,你可能能够搞懂它到底是如何运作的,”表示,“但是一旦这个神经网络相当大,比如说它有上百个层级,每层又由上千个单元组成,那么要搞懂它就显得有些天方夜谭。”

和MIT教授 的办公室毗邻,长久以来致力于将机器学习应用于医药。几年前,43岁的被诊断出患有乳腺癌。当然,这一诊断结果的本身的确不是什么好事,但让更沮丧的是如今前沿的数据统计系统和机器学习方法都不足以解决这些肿瘤的疑难杂症,也不能有效指导治疗。她认为人工智能有巨大的潜力变革目前的医药学,但是要开发这种潜力,人们不能只局限于用机器学习记载诊疗记录。设想可以更大程度上使用这些原始数据,显然她认为这些数据在目前都还没有被物尽其用:“想想看我们拥有多少大数据,多少有关病理的大数据?”

去年,在结束了癌症疗程后,和她的学生与麻省综合医院的医生们联手开发了一种系统,能够通过挖掘病理学报告来识别有特殊临床表现的病人,供研究者研习。然而,也同样认识到,系统在运作时需要给出合理的解释。之后,她与和另一名学生又进一步完善系统,使其能够摘取并且突出显示病理报告中具体表明特殊临床表现的文字片段。和学生还开发了另一种深度学习算法,能在乳房X线图像中探测出乳腺癌的早期征兆。现在她们正在致力于让系统能够解释其工作原理。“人类和机器必须得联手工作,相互提升。”认为。

美国军方已经投资数十亿用于机器学习项目,力图在将来可以操控汽车和飞行器,识别目标,从海量智能数据中筛选重要数据分析。不同于其他领域,军方运用算法时不允许容忍任何无法解释的程序,所以美国国防部在研究机器学习时,如何确认机器的可解释性成为一大难题。

DARPA开发的战斗机器狗

美国国防部高级研究计划局(DARPA)的项目经理David 目前正在监测一项名为“可解释性人工智能”的项目。曾经参与监测了Siri的开发项目,而如今他已经白发苍苍。他说,自动化已经不知不觉地覆盖了军事项目中不计其数的领域。目前,人工智能分析师正在尝试用机器学习鉴定海量监控数据中的模式。各种各样的自动化汽车或飞行器正在被陆续开发、测试。然而,没有士兵会喜欢一辆不知其原理的自动机器人坦克,当然,分析师也不可能在不知原因的状况下就对机器给出的信息做出相应反应。“机器学习系统给出错误警报是一件很常见的事,所以军事分析师必须借助系统做出的解释才能决定是否做出反应。”解释道。

David

今年三月,DARPA从学界和行业中挑选出了13个项目进行资助,隶属于监测的项目之下。这13个项目中,有些可以建立在华盛顿大学教授 的工程之上。和他的同事已经研究出解决方案,让机器学习系统为输出结果提供合理的解释。因此,通过这一解决方案,能够自动从数据中找到案例的机器人就能同时给出运作原理。比如用以识别恐怖分子邮件的机器系统是通过数百万的邮件学习后才能得出结论。在使用的方法后,机器系统还能够在邮件中标出关键词。此外,的团队还设计出了另一种方法,让图像识别系统突出强调图像中最重要的部分,以此解释其工作原理。

然而,这一方式和其他类似的方式,诸如研发的方法一样,都有同样的缺陷——系统提供的解释过于简单,在传送过程中极有可能丢失重要信息。“理想境界”是一旦AI和人类对话,它就能提供解释。显然,我们还没做到完美。”表示,“距离最后目标,我们还有很长的路要走。”

不止是癌症诊疗或是军方决策这种高风险领域,人工智能能否为决策提供解释对于科技发展为人类日程生活中的一部分至关重要。Tom 在苹果公司带领Siri的研发团队,他说,“解释性”至关重要,只有理解才能让Siri变为更智能,更高效的语音助手。目前并不想透露未来Siri将如何发展,但很显然,任何一个人在接受Siri的附近餐厅推荐时都想知道它推荐的原因是什么。作为苹果公司AI研究的主管及卡耐基梅隆大学的副教授, 将“解释性”视为将来人类与智能机器关系发展中的核心。“只有能够解释才能拥有相互信任。”他说。

然而,就连人类也有很多行为不能解释,人工智能可能同样如此。“就算有个人能够相对合理地解释(他/她的行为),这种解释也可能是不完整的,所以人工智能也会有这种状况,”Clune认为,“可能这就是所谓‘智力’吧,仅有一部分能够给出合理解释,而另一部分或是直觉,或是潜意识,或是神秘莫测。总之难以诉诸言表。”

如果的确如Clune说的那样,那么或许我们只能选择要么相信AI的决策,要么抛弃AI。当然,AI的决策在发展时必须和社会步调相吻合。就如人类社会建立在某种看不见的契约之上,我们设计的AI系统也必须尊重、符合我们的社会准则。一旦我们要设计出机器坦克或是“死刑机器”,我们必须保证他们的决策吻合于我们的道德体系。

为探究这些形而上学的概念,我也去塔夫斯大学会见了 教授。是一位赫赫有名的哲学家以及认知科学家,如今在研究人类的意识及思想。最近出版的关于人类意识的百科专著《从细菌到巴赫,从巴赫到细菌》(From to Bach and Back)中的某个章节提到,智力在进化过程中一个非常自然的阶段就是演化出了某种体系可以执行连自己都无法解释的行为。“而问题在于,人类应该如何自我调节以做出最明智的抉择,我们对于自我的标准应该定在哪里?对于‘智能’的标准又在哪里?”在那个位于田园牧歌般的大学校园里,的办公室显得有些杂乱。他如是对我说道。

对于科学家们对“可解释性”孜孜不倦的追求,他也提出了警示。“我认为,如果总有一天我们必须运用这些技术,并且生活将依靠于这些技术,那我们一定要尽可能了解这些技术给出的方案背后的原因和原理。”他说道。然而,鉴于我们至今都不能给出一个完美的解决方案,我们依然要对AI给出的解释也抱有警惕,就算是再智能的机器也同样如此。

“如果机器无法和我们一样给出决策的原因,”他说,“那么不要相信它。”