一文了解'智算中心'方案设计-中篇

- 科技

- 7个月前

- 58

七、方案设计—算力规划

智算中心方案的核心就是算力规划,算力的单位是什么?用GPU的哪个精度来算呢?不同的发展阶段,对算力默认定义是有差异的。结合个人理解概况如下:

1、HPC视角:我们以FP64算力精度作为标准,早些年以CPU芯片为主(CPU核心*主频*系数),后来随着GPU技术发展,以NV Tesla系列GPU为例使得算力规模和密度大幅提升。

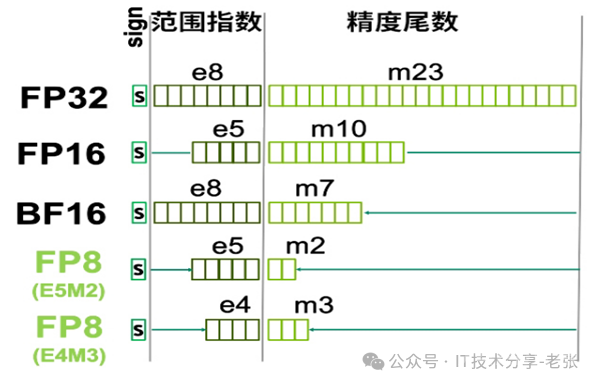

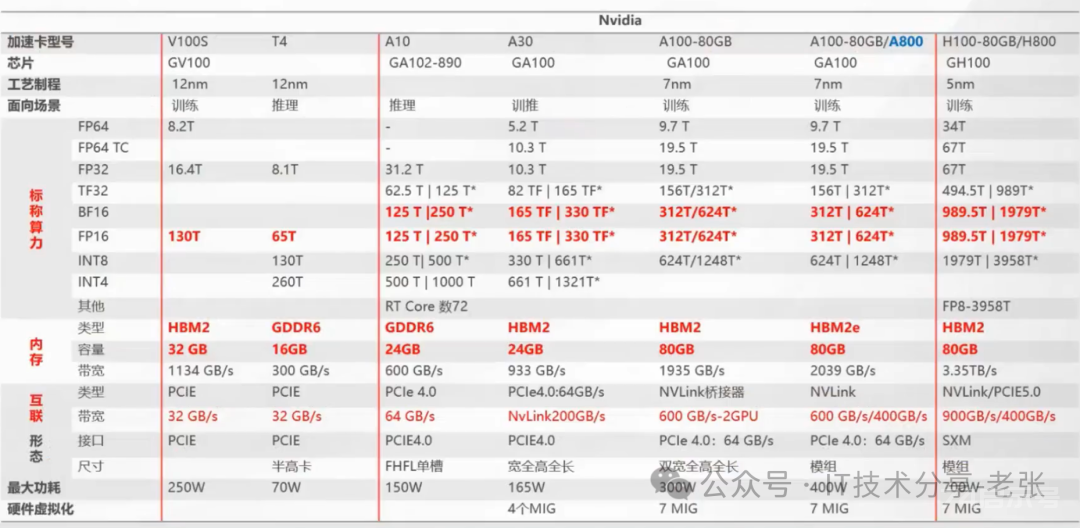

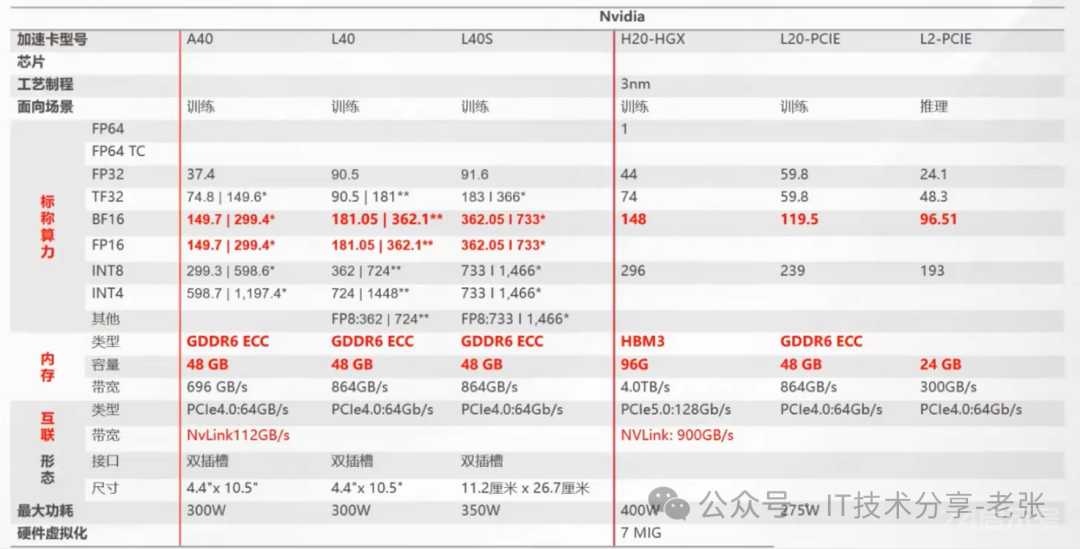

2、智算中心:智算中心以AI为主,常见场景有训练和推理,对算力精度的需求也有差异,如下图,常见的有FP32、TF32、FP16、BF16、INT8等,

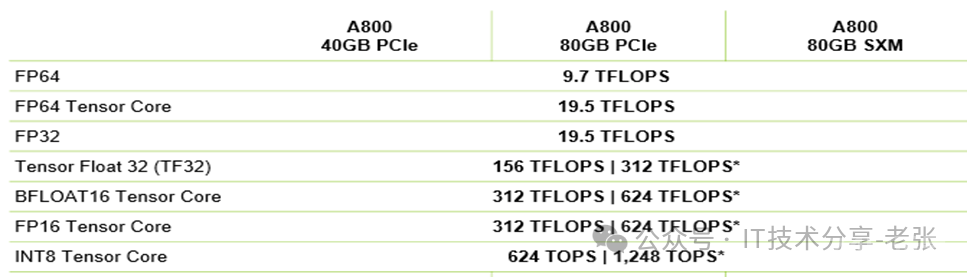

GPU卡的算力通常有多个数值,主要是因为在不同的浮点精度上表现的算力(每秒计算次数)是有所不相同,比如我们通常将FP16(半精的)作为智算中心方案的算力标准精度,当然部分客户要求必须是稠密算力,有的客户接受稀疏算力,以A800为例,它的 FP16 稀疏算力为624T,稠密为312T,如下图所示。

八、方案设计—算力的规划

算力规划的核心是产品选型和数量确定,而前提是要了解算力的类型、规模和用途

结合个人经验和网上公开的资料整理如下:

考虑因素

具体分析

备注

1、算力用途

我们以训练需求为例

2、算力类型

我们以N卡算力为例举例

3、算力规模

我们以算力租赁的需求举例

举例

具体的算力规模:以1000P为例,我们以H100 整机为单位,每台可提供FP16 稀疏算力16P

九、方案设计—算力的常见问题

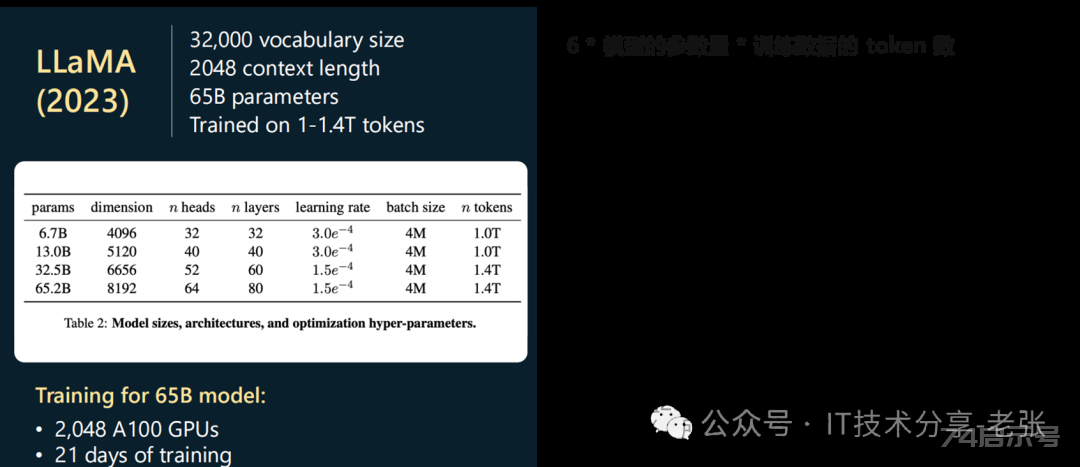

算力规划时往往还需要和大模型的训练相结合。还需要了解以下问题:

能否根据具体的模型参数量,结合算力的规模,计算出训练所需时间?

能否根据具体的模型参数量,计算出训练、推理场景对GPU显存大小的需求?

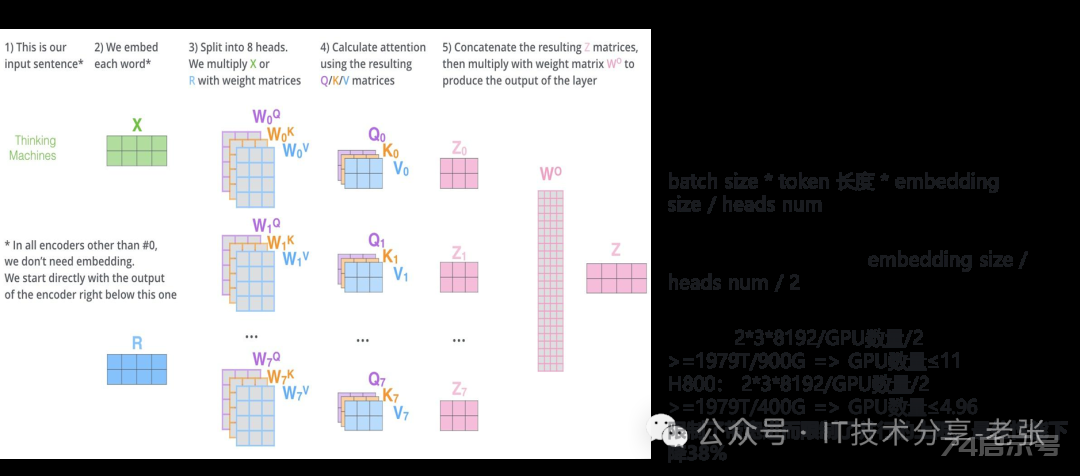

能否根据GPU单卡算力和卡间通信带宽推算最佳的并行方案,并用于卡的选型和集群网络方案设计?

情况1:根据主流的模型数据量大小,结合客户算力规模,计算出训练所需时间,从而定制最优算力方案

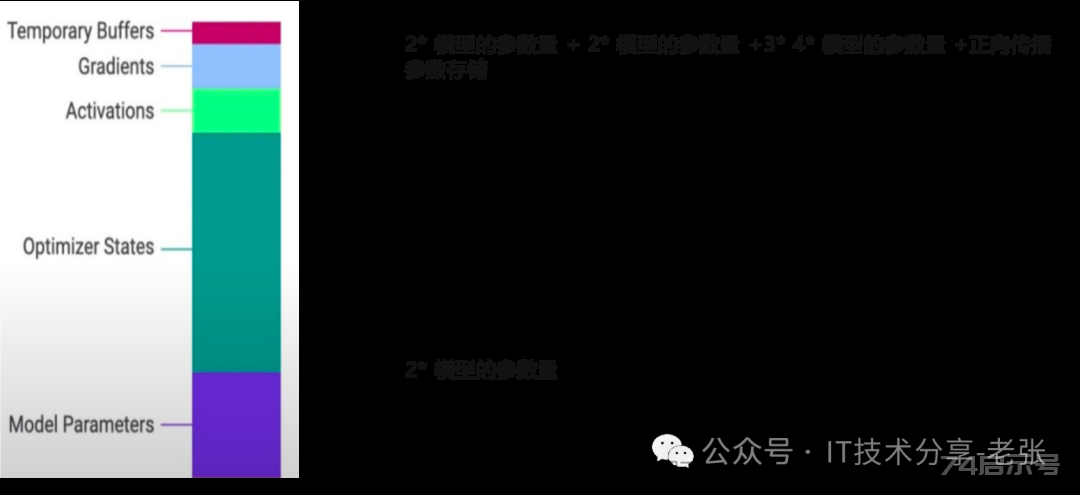

情况2:能否根据具体的模型参数量,计算出训练、推理场景对GPU显存大小的需求?

情况3:根据卡的算力和带宽推算最佳的并行方案,并用于卡的选型和集群网络方案设计

十二、方案设计—NV卡的常见参数一览

十四、智算中心网络需求分析

1、智算中心-网络方案背景:

智算中心核心业务场景-大模型训练中大规模的参数对算力和显存都提出了更高的要求。以GPT3为例,千亿参数需要2TB显存,当前的单卡显存容量不够。为了缩短训练时间,通常采用分布式训练技术,对模型和数据进行切分,采用多机多卡的方式将训练时长缩短到周或天的级别,算力集群成为必然,通过网络将多台节点构建出一个计算能力和显存能力超大的集群。

2、智算中心-网络需求分析:

联接这个超级集群的高性能网络直接决定了智算节点间的通信效率,进而影响整个智算集群的吞吐量和性能。要让整个智算集群获得高的吞吐量,高性能网络需要具备低时延、大带宽、长期稳定性、大规模扩展性和可运维几个关键能力。

十五、智算中心-低延时的RDMA网络

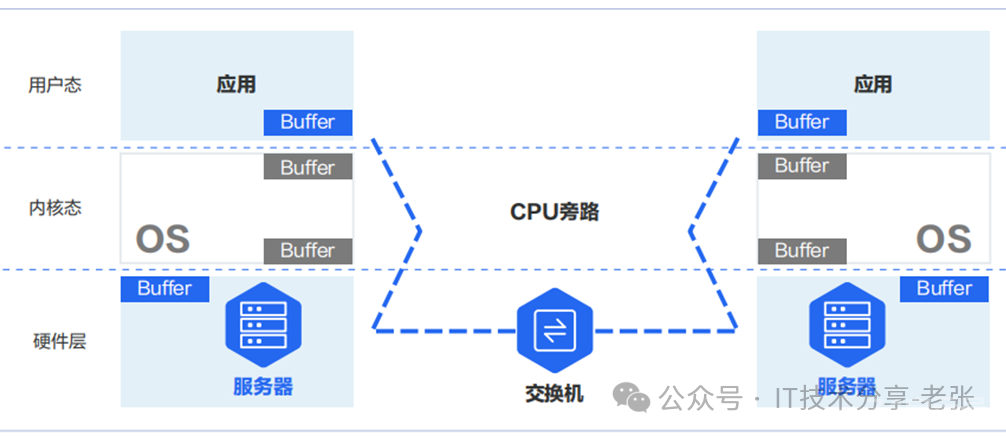

RDMA技术-降低多机多卡间端到端通信时延。RDMA可以绕过操作系统内核,让一台主机可以直接访问另外一台主机的内存。实现RDMA的方式有、、、iWARP四种。其中 技术已经被淘汰,iWARP 使用较少。当前智算中心的RDMA技术主要采用的方案为 和 两种,下图为RDMA 通信示意图。

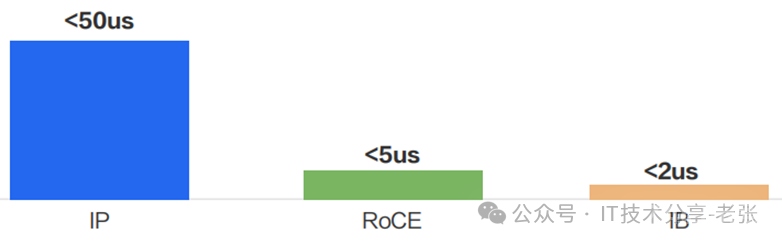

IB和 与传统IP的端到端时延在实验室的测试数据显示,绕过内核协议栈后,应用层的端到端时延可以从 50us(TCP/IP),降低到 5us(RoCE)或 2us(IB)。

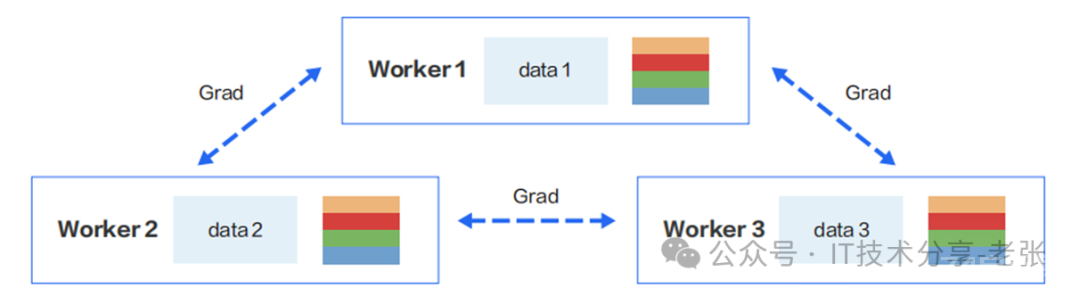

十六、智算中心-高带宽需求等

高带宽需求:RDMA解决了低延时,但是在进行计算任务时,GPU主机集群内部的计算节点需要将计算结果快速地同步给其他节点,以便进行下一轮计算。在结果同步完成前,计算任务处于等待状态,不会进入下一轮计算。如果带宽不够大,梯度传输就会变慢,造成卡间通信时长变长,进而影响加速比。

1、稳定性需求:由于计算量比较大,分布式训练任务有可能需要数天或数周。在训练期间如果出现网络不稳定的问题,会影响整个训练任务的进度。

2、大规模需求:分布式训练中要使用千卡或万卡规模的 GPU 来缩短整体训练时长。这就需要智算网络能够具备支持大规模 GPU 服务器集群的能力

3、易运维需求:在成百上千张GPU卡的智算集群中,集群的可运维性、可管理性是需要重点考虑的维度。

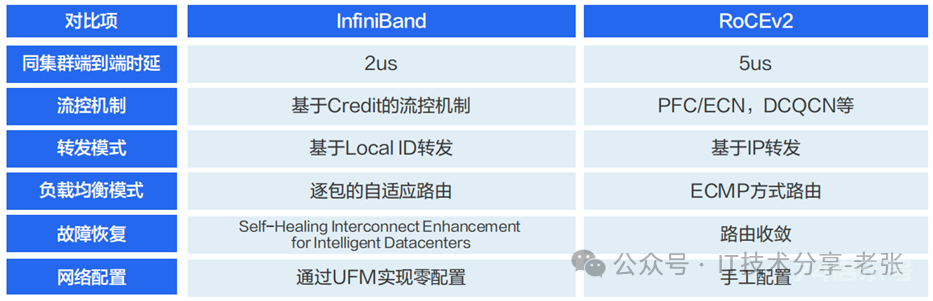

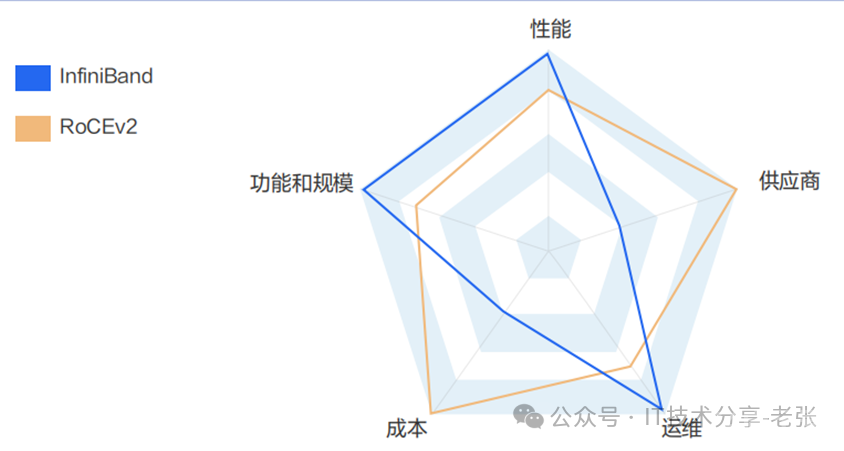

十七、智算中心网络方案-IB和ROCE对比

RoCE方案相对于 方案的特点是通用性较强和价格相对较低。除用于构建高性能 RDMA 网络外,还可以在传统的以太网络中使用。但在交换机上的 、PFC、ECN 相关参数的配置是比较复杂的。在万卡这种超大规模场景下,整个网络的吞吐性能较 网络要弱一些。

从技术角度看, 使用了较多的技术来提升网络转发性能,降低故障恢复时间,提升扩展能力,降低运维复杂度, 和 对比,各有优劣势;

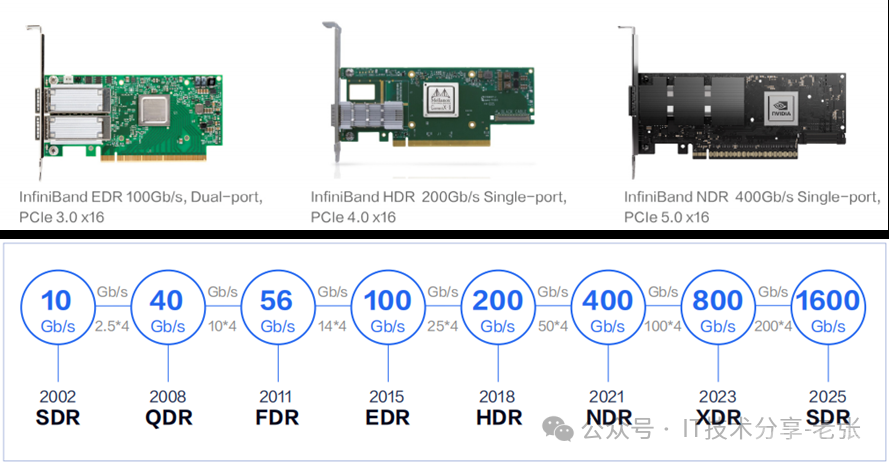

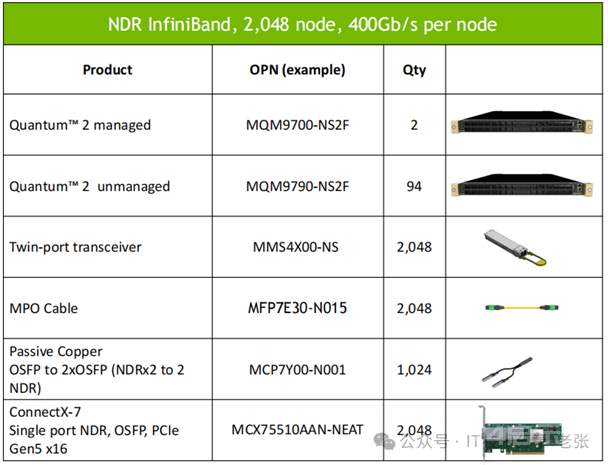

十八、智算中心网络方案-IB相关产品

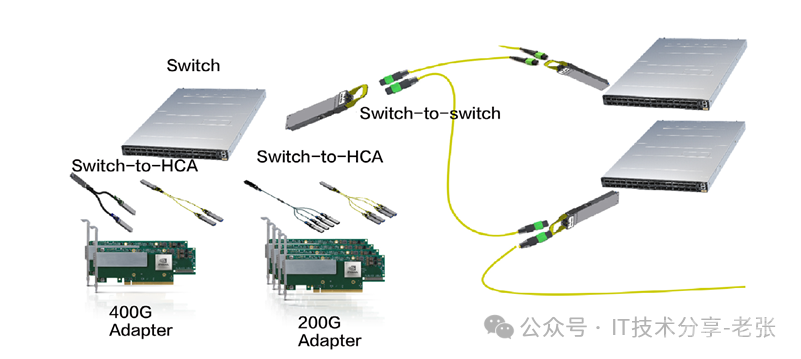

网络的关键组成包括IB交换机、 IB网卡、IB连接线缆及子网管理产品等。

2021 年, 推出了的-2 系列交换机(64*400G)。交换机上有32个 800G OSFP接口,需要通过线缆转接出64个400G QSFP。

支持 网卡的厂家以 为主。下图是当前常见的 网卡。 网卡在速率方面保持着快速的发展。 的 和 的 NDR的网卡也已经开始商用部署。

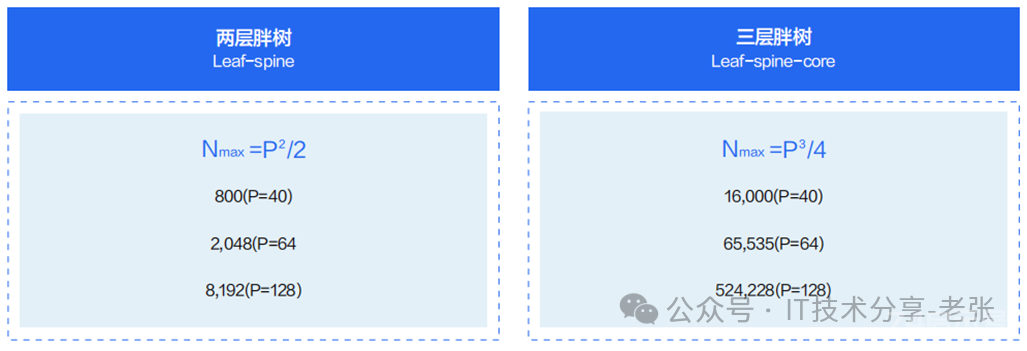

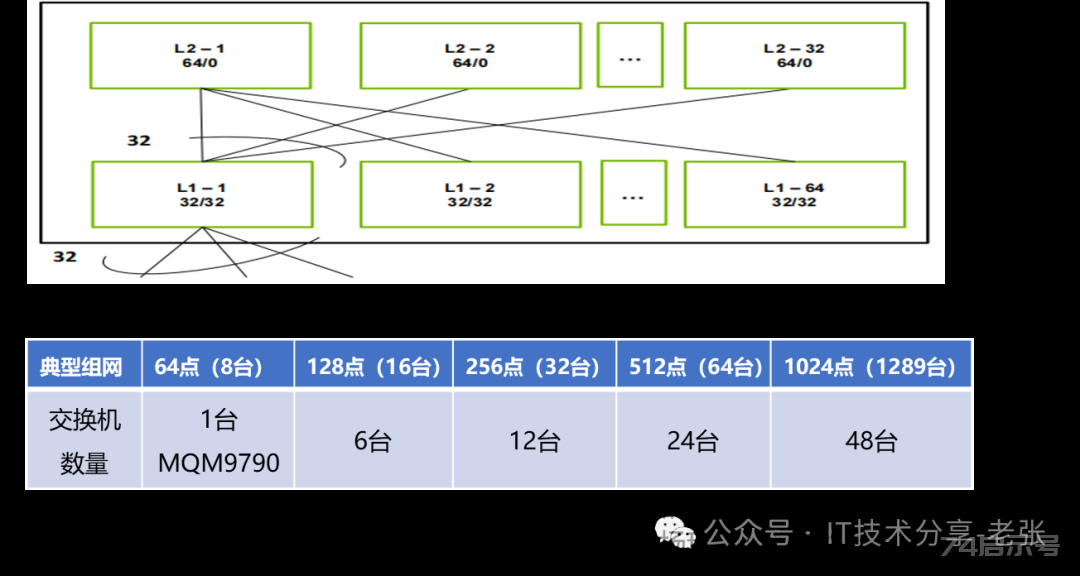

十九、智算中心网络方案-IB互联和胖树架构

IB组网通常采用无阻塞网络设计,其关键是采用 Fat-Tree(胖树)网络架构。交换机下联和上联带宽采用 1:1 无收敛设计,即如果下联有32个 的端口,那么上联也有 32个 的端口。

不同网络架构容纳的 GPU 节点数量

两层胖树和三层胖树最重要的区别是可以容纳的 GPU 卡的规模不同(这里默认GPU和IB网口数量是1:1)。在上图中 N 代表 GPU 卡的规模,P 代表单台交换机的端口数量。比如对于端口数为 64 的交换机,两层胖树架构可容纳的 GPU 卡的数量是 2048卡,三层胖树架构可容纳的 GPU 卡的数量是 65,535卡。

网络需要专用的线缆和光模块做交换机间的互联以及交换机和网卡的互联。

二十、智算中心网络方案-举例

网络规划的原则是先确定GPU服务器的数据,再根据每台的网卡数和网卡类型计算组网情况,以256台实配8张400G的服务器为例,共计2048个网卡,这里要以网卡数据为单位进行规划。

1、计算公式:用2048÷32=64,计算出leaf交换机数量,64÷2=32,向上取整数得出32,总计96台;

2、交换机互联用的双口模块:=2048个,因为每对用2根MPO线缆,所以线缆数也是2048;

3、因为是32个双口400Gb,所以需要1024根Y型线缆,转出来2048个接头用于网卡互联。

上一篇

局部转移皮瓣——菱形皮瓣

下一篇

地质十大运动你知道几个